Re new

전문가 칼럼

챗GPT 편리함,

이면의 리스크를 묻다

글 이임복

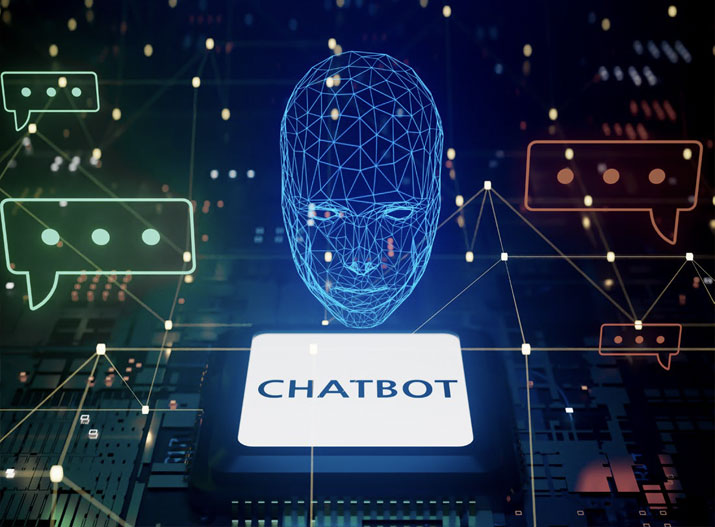

2022년 11월 챗GPT가 출시되고 벌써 2년 넘는 시간이 지났다. 그동안의 변화는 놀라웠다. 친구처럼 대화하는 걸 넘어 자료 요약, 분석, 엑셀파일 생성, 작사, 다양한 글 작성에 이미지 생성과 영상 생성까지, 생각하는 거의 모든 것들을 챗GPT를 비롯한 생성형 AI들이 할 수 있게 됐다.

이렇다 보니 챗GPT를 잘 쓰는 사람들은 ‘GPT 없이는 일하는 걸 상상조차 할 수 없다’고 말할 정도다. 반면, 챗GPT와 간단한 인사말 말고는 해본 적 없는 사람들도 여전히 많다. 이렇게 AI 활용 격차가 벌어지다 보니, 지금이라도 따라가지 않으면 안 될 것 같은 불안감이 생긴다. 하지만 GPT가 주는 편리함에 빠지기 전에, 주의해야 할 점, 리스크부터 먼저 생각해야 한다.

이 리스크는 국가 단위의 AI 구축인 ‘소버린 AI’부터 기본소득 같은 거대한 주제까지도 연결되고, ‘어떤 AI를 써야 가성비가 좋을까’ 하는 아주 개인적인 고민까지 이어진다. 여기서는 챗GPT를 비롯한 생성형 AI를 사용할 때 꼭 생각해 봐야 할 3가지 리스크를 정리해 본다.

이 세 가지 외에도, 더 심각한 위기가 있다. 바로 ‘생각하지 않는 사람들’이 늘어나는 것이다. 사실 완전히 새로운 건 아니다. 인터넷이 처음 등장했을 때도, 구글 검색이 보편화됐을 때도, 위키피디아가 널리 퍼졌을 때도 한 번씩 겪었던 일이다.

지금은 챗GPT가 뭐든 해주니까, 검색도 GPT에게, 보고서 작성도 GPT에게, 칼럼 쓰기도 GPT에게, 심지어 간단한 이메일 작성까지 GPT에게 맡기는 경우가 많아지고 있다.

그러다 보니, 문의가 오면 GPT가 답변을 하고, 그 답변을 보고 또 다른 사람이 GPT에게 질문해서 다시 답변을 만드는, 일종의 GPT끼리의 대화가 벌어지는 웃지 못할 상황도 생긴다. 블로그 리뷰나 쇼핑몰 댓글도 점점 GPT가 쓴 글들로 채워지고 있다.

어떻게 해야 할까? 지금 당장 우리 모두가 GPT 사용을 멈춰야 할까? 그렇지는 않다.

이처럼 광적으로 확산되고 있는 AI의 생성물들은 언젠가는 한계에 다다르게 되어 있다.

그 이후엔 결국, 진짜 자기 생각을 담은 글을 쓸 수 있는 사람들, 자기만의 결과물을 만들어낼 수 있는 사람들, ‘오리지널리티’를 가진 사람들이 주목받게 될 수밖에 없다.

챗GPT가 나오기 전에도 많은 사람들이 학교 과제나 보고서를 인터넷에서 짜깁기했다. 어차피 검색하면 찾을 수 있는 답이라면, 문제를 바꾸면 된다. GPT의 도움을 받더라도, 그걸 스스로 이해했는지 확인할 수 있는 방식으로 질문을 바꾸면 된다

글쓴이 소개 이임복

현) 세컨드브레인연구소 대표, 인터렉티브북스 대표, 한국경제인협회 MWC 모더레이터, 한국금융연수원 겸임교수, 유튜브 일상 IT 운영자